某运营商数字集成部对外提供大模型的推理服务,考虑到用户的需求较为复杂,有调用多个不同种类的大模型的需求。

但是目前大模型动辄4卡的配置让运营商的GPU资源捉襟见肘,无法更大规模扩展其模型推理业务。

通常推理任务为满足理想的用户体验,会将推理模型常驻显存,24 小时不中断,以便拥有较快的响应速度。但是这类常驻任务一般算力利用极低,而且潮汐效应明显。

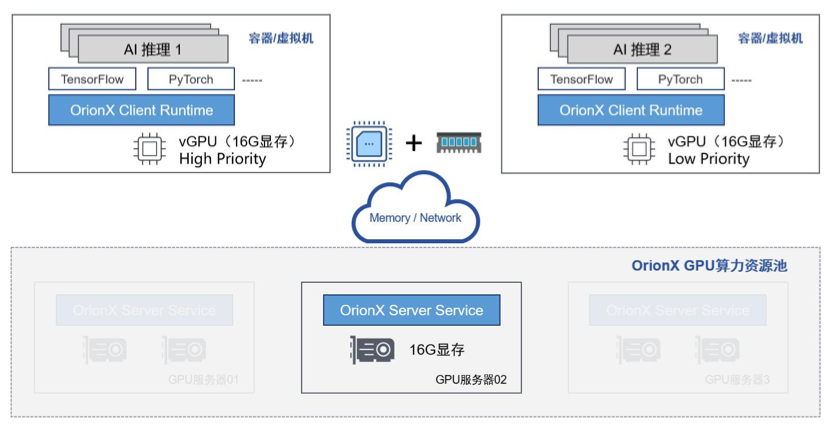

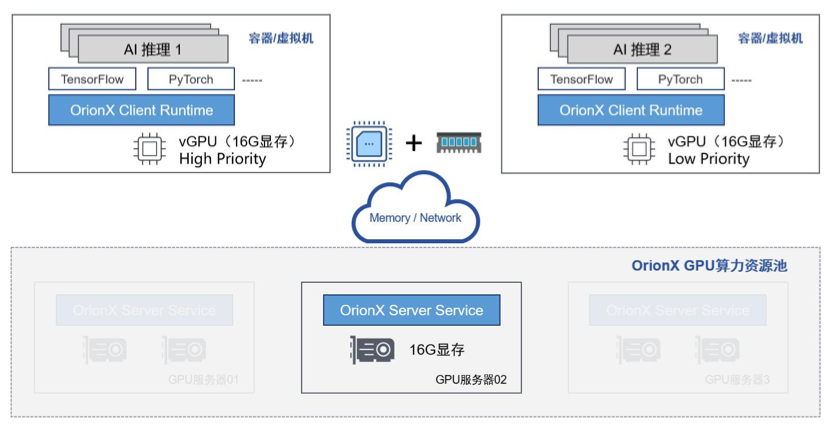

OrionX 支持多任务潮汐叠加。通过“显存超分”,OrionX 会调用系统内存补充 GPU 显存,在逻辑上扩大 GPU 显存的承载容量, 从而支持多个常驻显存的长尾任务叠加在同一个物理GPU 上,提高单个 GPU 的承载量,充分利用 GPU 闲置算力。

根据业务特点,OrionX 还支持不同任务设置不同优先级,从而保证突发高优先级任务的服务质量。

该方案通过引入OrionX技术,为运营商数字集成部提供了一套高效、灵活且具有前瞻性的大模型推理服务优化方案,其核心价值体现在以下几个方面:

• 显著提升GPU资源利用率。传统模式下每个大模型推理任务都需要独占一块或多块GPU,并且由于模型常驻显存的特性,导致大量GPU算力处于闲置状态。OrionX的“显存超分”技术通过将系统内存与GPU显存进行逻辑整合,使得多个模型可以共享同一块物理GPU的资源,从而大幅提升GPU的整体利用率,减少资源浪费。

• 支持多模型并发与弹性调度。面对用户复杂多样的模型调用需求,OrionX支持多种大模型在同一GPU上并行运行,并根据业务负载动态调整资源分配。这种弹性调度机制不仅提升了系统的灵活性,也有效应对了用户请求的潮汐效应,确保在高峰期依然能够稳定响应。

• 保障服务质量(QoS)与优先级控制。不同用户或业务场景对响应速度和服务质量的要求不同。OrionX支持基于任务优先级的资源调度策略,在突发高优先级任务时,能够快速抢占资源并优先执行关键任务,从而保证核心业务的服务体验不受影响。

• 降低硬件投入与运营成本。通过提高单个GPU的承载能力,运营商无需频繁采购高端GPU设备即可满足日益增长的模型推理需求,从而大幅降低硬件采购成本和数据中心的电力、散热等运维开销。同时,资源的集约化使用也有助于实现绿色低碳的可持续发展目标。

• 增强平台服务能力与市场竞争力。借助OrionX提供的多任务调度、优先级管理和资源隔离能力,运营商可以对外提供更加多样化、高质量的大模型推理服务,吸引更多的企业客户入驻平台,拓展收入来源。这不仅提升了平台的技术壁垒,也为未来构建AI生态打下了坚实基础。

• 支撑未来大规模AI推理业务扩展。随着AI应用的不断演进,模型种类和数量将持续增加,推理任务也将更加复杂。OrionX提供的可扩展架构和智能调度机制具备良好的前瞻性,能够支撑运营商在未来几年内持续扩展其AI推理业务规模,而不受制于硬件资源瓶颈。

总结来看,本方案有效提升了资源利用效率,优化了服务质量,并在降低运营成本方面取得了良好成效,是运营商面向AI时代打造高性能、低成本、可扩展的大模型服务平台的理想选择。它不仅解决了当前面临的GPU资源紧张问题,更为未来的智能化业务发展提供了强有力的技术支撑。