当前,生成式AI的快速发展(2022年市场规模已达万亿美元)正推动算力需求呈指数级增长。以BLOOM模型为例,其训练过程消耗的能源相当于一个美国家庭41年的用电量,碳排放量接近25次跨美加航班的总和,凸显算力高能耗与环保压力。传统GPU因资源分散、利用率不足30%,且采购与运维成本高昂,难以满足AI业务的敏捷扩展需求。与此同时,国产芯片加速崛起(2025年自给率目标70%),叠加美国对高端芯片的出口限制,倒逼行业向信创生态转型。此外,AI服务器单机功耗高达1600W~6500W,远超普通服务器的750W~1200W,亟需通过能效优化与绿色技术(如资源池化、超分调度)降低单位算力能耗,以符合《算力基础设施高质量发展行动计划》等政策要求。

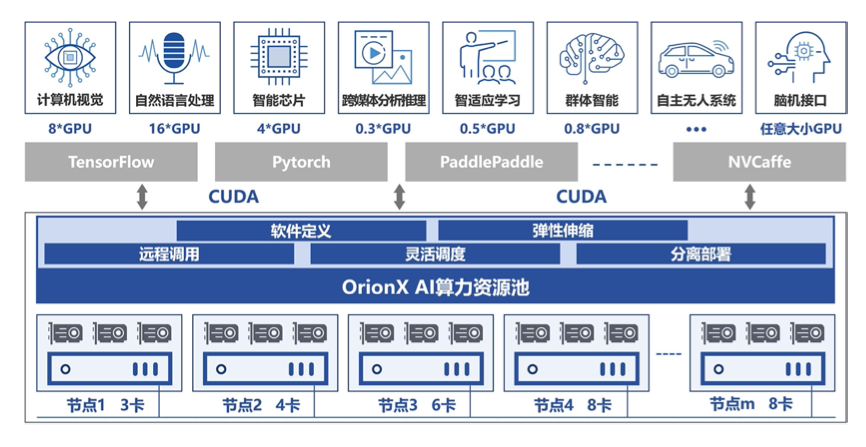

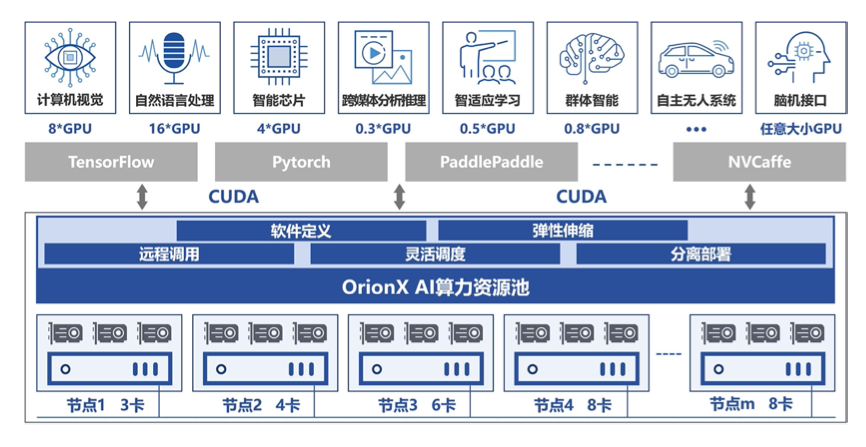

基于上述挑战,算力融合和池化成为必然趋势,OrionX 帮助客户构建数据中心级 AI 算力资源池,使用户应用无需修改就能透明地共享和使用数据中心内任何服务器之上的 AI 加速器。OrionX 不但能够帮助用户提高 AI 算力资源利用率,而且可以极大便利用户 AI 应用的部署。

OrionX 通过软件定义 AI 算力,颠覆了原有的 AI 应用直接调用物理 GPU 的架构,增加软件层,将 AI 应用与物理 GPU 解耦合。AI 应用调用逻辑的 vGPU,再由 OrionX 将 vGPU需求匹配到具体的物理 GPU。OrionX 架构实现了 GPU 资源池化,让用户高效、智能、灵活地使用 GPU 资源,达到了降本增效的目的。

OrionX 通过构建 GPU 资源池,让企业内的 AI 用户共享数据中心内所有服务器上的 GPU算力。AI 开发人员不必再关心底层资源状况,专注于更有价值的业务层面,让应用开发变得更加便 捷。OrionX 产品有如下优势:

1.提高利用率

• 支持将 GPU 切片为任意大小的 vGPU, 从而允许多 AI 负载并行运行, 提高物理 GPU 利用率。

• 提高 GPU 综合利用率多达 3-10 倍, 1 张卡相当于起到 N 张卡的效果, 真正做到昂贵算力平民化。

2.高性能

• 相比于物理 GPU, OrionX 本地 vGPU 性能损耗几乎为零, 远程 vGPU 性能损耗小于 2%。

• vGPU 资源隔离,并行用户无资源互扰。

3.轻松弹性扩展

• 支持从单台到整个数据中心 GPU 服务器纳管,轻松实现 GPU 资源池的横向扩展。

• 全分布式部署,通过 RDMA(IB/RoCE)或 TCP/IP 网络连接各个节点,实现资源池弹性扩展。

4.灵活调度

• 支持 AI 负载与 GPU 资源分离部署,更加高效合理地使用 GPU 资源。

• CPU 与 GPU 资源解耦合,两种服务器分开购买、按需升级、灵活调度,有助于提升数据中心基础设施价值。

5.全局管理

• 提供 GPU 资源管理调度策略。

• GPU 全局资源池性能监控,为运维人员提供直观的资源利用率等信息。

6.对 AI 开发人员友好

• 一键解决 AI 开发人员面临的训练模型中 GPU/CPU 配比和多机多卡模型拆分问题,为算法工程师节省大量宝贵时间。