随着大数据平台的建立和完善,包括ETL处理、数据仓库和数据湖的构建,以及大模型硬件资源的准备就绪,如大模型一体机和推理框架和平台的部署,我们正站在一个技术革新的前沿。

大模型正常工作的三个关键要素是指令、知识和工具。指令告诉模型该做什么,知识赋予模型相关的记忆内容,工具给模型参考或者让模型自己去查资料。这三个要素都离不开数据,而数据是工具给模型的反馈结果。

尽管理想状态下数据应无缝转化为模型,但现实中存在诸多问题导致理想和现实存在鸿沟:

• 逻辑丢失:数据间的关联性未被保留,模型无法理解上下文;

• Token限制:海量数据难以一次性输入,分析效率受限;

• 知识割裂:数据与业务知识脱节,模型输出脱离实际需求。

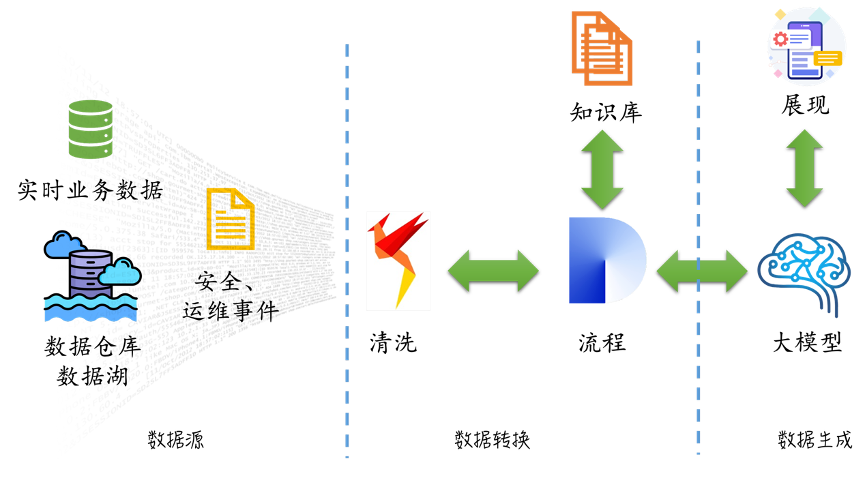

为解决这些问题,我们采用了一个数智融合的架构设计:

该架构分三层:

1、数据源:涵盖实时业务数据、数据仓库 / 湖、安全运维事件,多源采集。

2、数据转换:清洗治理数据,流程串联业务 / 运维逻辑,双向衔接知识库(存储规则、经验),构建知识沉淀与调用闭环。

3、数据生成:大模型对数据做智能分析(根因、预测等),结果经可视化展现供用户交互,大模型与流程双向协作。

整体形成 “采集→加工→智能输出” 闭环,知识与模型互补,支撑运维、业务等场景的实时决策与优化 。

本方案通过三大核心能力,助力企业突破数据与模型融合的瓶颈,实现AI在复杂业务场景的深度赋能:

1. 弥合数据裂隙

构建多维度关联网络:通过增强数据间的逻辑关系,打破数据孤岛;

跨数据源协同分析:整合异构数据(数据库、日志、文档等),实现ª多维信息关联,提升模型对业务场景的深度理解能力。

2. 疏通模型瓶颈

规避输入限制:采用分批次数据导入机制,有效规避大模型Token限制,保障海量数据的完整分析;

融合分析优化:通过数据源合并处理,降低阶段性分析带来的信息偏差,确保模型输出结果的连贯性与准确性。

3. 深度辅助理解

内容补全与可视化:对纯文本信息进行语义增强,将复杂系统架构、故障关联等抽象内容转化为可视化图表(如拓扑图、流程图),直观呈现关键逻辑;